개요

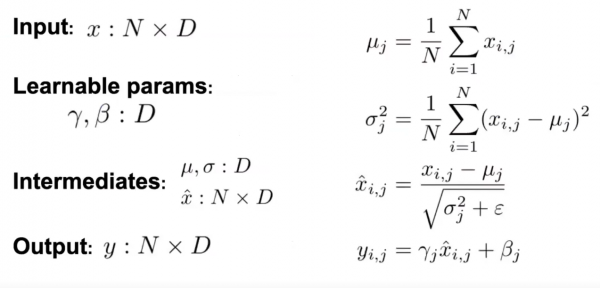

ICML'15논문에서 소개된 batch normalization은 딥러닝의 학습 능력, 속도 그리고 안정성을 획기적으로 높힌 알고리즘이었다. Batch normalization은 Input들의 평균과, variance를 구하여 intermediates를 구하여 감마와 베타값을 학습 시켜서 normalization과 학습을 시킨것이다. 이때 hyper parameter인 감마와 베타의 초기값 설정은 결과값에 매우 민감함으로 유심히 설정하여야 한다.